前言

少了风花雪月的互联网光彩,也没有吸金吐银的资本运作游戏,或许它本应更加纯粹一部分。也许你之前并不了解它,但它就在那里——数据中心Data Center互联网行业最后方的一块基石,一块保留了那么一点传统领域工程师情怀的地方。

今天,互联网充满了颠覆和改造事物的力量,不经意中,数据中心Data Center技术也随着这股力量扬帆起航,让我们看看它到底会驶向何方。

该篇文章比较冗长,各位看官可以根据需要选择章节。第一部分,制冷与数据中心Data Center节能的逻辑关系;第二部分,腾讯历代数据中心Data Center采用的制冷节能技术;第三部分,国外数据中心Data Center有意思的制冷解决方案;第四部分,数据中心Data Center未来制冷节能的一部分看法。

一、制冷与数据中心Data Center节能的逻辑(备注:数据中心Data Center领域的制冷,泛指将数据中心Data Center内IT设备等产生的热量搬运出去,并维持内部温湿度的整个过程。)

1、最大的山头,节能战役成败的关键

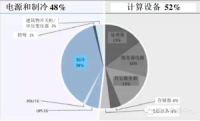

拿数据说话,美国环保署提交给美国国会的一份研究报告称,在数据中心Data Center的全部电源消耗中,制冷占到40%左右;某公司行业调研分析数据中心Data Center能源使用情况后发现,制冷系统(由制冷和空气传输设备组成)占用38%的能源消耗如图所示:

数据中心Data Center能耗分布

毋庸置疑,制冷节能对数据中心Data Center具有十分重要的价值。既然值得去做,那么接下来看看行业里面的领先者,做的情况如何。

2、前仆后继,大有可为

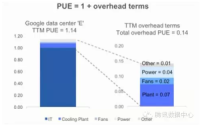

Google在2012年数据中心Data Center峰上会公布其2011年(也就是3年前)的某数据中心Data Center12个月的PUE数据。全年PUE为1.14,其中制冷占到9%(产冷7%,散热2%),供电占到4%,其他还有1%,(相比IT负载功耗),如下图分布:

Google公布其某数据中心Data CenterPUE情况

更多的数据就不列举了,从40%的比重下降到不到10%,已经证明了数据中心Data Center的制冷节能是有空间做好的。可能有人怀疑,Google的成功无法被复制,那我们暂时跳出数据中心Data Center的范畴,看看制冷这个专业本身的情况。

3、站在巨人们的肩膀上

1755年,W.Cullen发表了《液体蒸发制冷》论文,开创了人工制冷的新纪元。1856年,苏格兰人J.Perkins发明了压缩式制冷机,从此蒸汽压缩式制冷机在制冷装置的生产和应用中占了统治地位。1924年,我国第一个安装中央空调的商用建筑。坐落于上海延安西路的嘉道理大理石大厦,使用了美国约克公司活塞式冷水机组。1931年,上海某纺织厂采用地下井水进行喷雾加湿,我国最早采用喷淋式的空调调节系统工厂。1950年,国内高校开设了暖通空调专业。

可见,制冷学科基础非常深厚,积累了大量成熟的技术理论和实践,完全应该可以支撑数据中心Data Center节能的技术要求的。

4、因地制宜,为我所用

本人制冷专业本硕毕业,对制冷充满敬畏,所以刚进入数据中心Data Center领域时不禁内心有一个疑问:互联网公司、数据中心Data Center细分行业能在制冷技术上取得一部分什么进展?最近看到一篇评价ElonMusk的文章,有了一点启发。

ElonMusk前后做过PayPal、SpaceX、SolarCity、Tesla,他进入每一个领域,都有一个共同点——整合成熟技术去入侵那些“沉迷”于基础研发而长期无法突破的行业。他并未解决基础问题,而是跨界整合。

SpaceX用成熟的液体火箭技术,降低了火箭的制造和发射成本,不像NASA那样常年执着于基础研发。Solarcity也没有在太阳能板技术上取得突破,而只是创造了一种新的消费融资模式。Tesla则是将成熟的服务器集群管理和18650锂电池技术进行整合,创造出强大的BMS.

Elon Musk和他的Tesla、SpaceX

数据中心Data Center行业,不关注突破制冷基础技术,技术整合才是关键!也许这就是前面问题的回答吧。

5、冲锋陷阵,但勿忘初衷

前面谈到数据中心Data Center制冷节能值得去做,Google也做好了,专业本身也有条件让我们去做,牛人Elon Musk也告诉我们如何去做,那么数据中心Data Center制冷节能真的就一帆风顺吗?

Facebook的第一个自建数据中心Data Center碰到了一个让运维的啼笑皆非的麻烦:机房里形成了另一朵实实在在的云,而且开始下雨。“那几分钟,你站在脸书的机房里,噼里啪啦,四周一片烟花烂漫,无数的超薄服务器随不可抗拒的物理原理而去。”运营负责人如此回忆道。

对于数据中心Data Center来说,节能诚可贵,稳定价更高!制冷新技术,勿作萧何,一定要小步试错,稳定逐步的去推广。

小结:数据中心Data Center存在很大的制冷节能空间和潜力,成功的行业先驱告诉我们此事之可行性,制冷专业本身又具有深厚的基础实力条件,成功之关键在于对技术的整合和深度定制,最后以期实现高稳定性的制冷节能解决方案。这就是自己所理解的数据中心Data Center制冷节能逻辑:

数据中心Data Center与制冷节能

二、腾讯历代数据中心Data Center制冷节能技术

(备注:针对腾讯自建机房,腾讯承担了其规划运营优化等多方面的工作,可靠承载了公司数以十万计的自用服务器)

1、腾讯历代数据中心Data Center制冷技术总览

第一代数据中心Data Center,出现在2007年深圳宝安,它的特征为地板下送风以及冷通道封闭;第二代数据中心Data Center,出现在2010年天津,在第一代基础上,采用了离心冷水机组、板换自然冷、新风自然冷以及水蓄冷的技术;第三代数据中心Data Center,出现在2012年的宝安四期,这一时期采用了大量的CFD仿真、水平行间送风以及模块化的设计理念;

腾讯历代数据中心Data Center制冷技术总览

2、腾讯第一代数据中心Data Center制冷节能,末端冷量利用优化

早期的数据中心Data Center机房内,普遍采用风冷精密空调,仅为了解决用户眼前的资源需求问题,尚未涉及到节能层面。随着业务规模和服务器数量的增长,宝安一期机房,采用了风冷精密空调+地板下送风的方式;宝安三期机房,则采用了风冷精密空调+地板下送风+封闭冷通道的形式。

第一代数据中心Data Center制冷节能情况

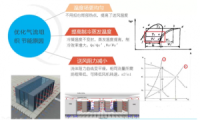

可见,通过简单的气流组织优化,提高了末端冷量的利用效率,达到了显著的制冷节能效果。(备注,图中PUE为某一时期的横向对比,非年平均值)那么优化气流组织,更进一步的分析其节能原因如下图所示:

第一代制冷节能原因分析

表面上理解,通过气流组织优化房间内温度场更加均匀,规避了“大马拉小车”的现象。但实质上还是会对冷机和风机的有性能影响:1、由于送风温度升高,制冷蒸发温度有所提高,在冷凝温度不变的情况下,从压焓图上可以看到,单位流量的制冷量提高而压缩机的压缩功减少,制冷效率提升;2、由于送回风通道阻力下降,管路阻力曲线变得更加平缓,对应于相同流量的压头下降,所以匹配的风机转速降低,风机功耗下降。

3、腾讯第二代数据中心Data Center制冷节能,优化冷源产冷

相比于第一代的宝安数据中心Data Center,腾讯自建天津数据中心Data Center增加了离心冷水机、板换自然冷以及水蓄冷的解决方案,制冷能耗进一步降低。

第二代数据中心Data Center制冷节能情况

在第一代宝安机房的末端冷量优化的基础上,天津数据中心Data Center更多是在制冷源头上做文章。如何优化冷源产冷,进一步分析其节能原因:

第二代制冷节能原因分析

解释如下:1、相比于风冷精密空调,采用冷冻水系统,冷机制冷的冷凝温度可以控制在更低的范围内。在制冷蒸发温度不变的情况下,从压焓图上看到,冷凝温度降低使得单位流量下制冷量增大,而所消耗的压缩功减小,制冷效率提升;2、通过提高冷冻水送水温度,直接提高了制冷蒸发温度,使得冷机更加节能;3、由于是采用的水系统,可以很灵活的通过板式换热器来实现Free Cooling,省去了压缩机的压缩功以及风冷机制冷剂压力控制所需要的额外功耗等;4、关于水蓄冷,通常说只省电不节能,这个说法应该还不够全面。从典型的离心机工作性能曲线上看到,压比随着流量增大而下降,制冷效率则存在最佳设计工况点。所以通过水蓄冷,调节负载分配,也是可以起到一定节能效果的(尤其在负载较低的情况下)。

腾讯第二代+数据中心Data Center制冷节能,天津实验机房补充一下腾讯二代+的制冷解决方案,出现在天津自建数据中心Data Center实验机房,采用了封闭热通道+新风自然冷的方式。该机房的PUE做到了1.3以下,但更重要的是,通过实验性质测试我们队空气质量、过滤成本等有了更多的经验和认识。

第二代+数据中心Data Center制冷节能情况

取消“制冷”环节,也成为数据中心Data Center制冷节能的共识。

4、腾讯第三代数据中心Data Center制冷节能,精细化制冷

典型代表是宝安四期微模块机房,由于机楼限制,采用了传统风冷冷水机组再加上MDCv1.0(目前最新版本已到v2.2)的解决方案,在深圳的秋冬季节将PUE降低到了1.4左右的水平。

第三代数据中心Data Center制冷节能情况

这个阶段,通过定制末端水分配单元以及列间水平送风空调,用标准化、产品化的设计和交付,实现精细化制冷降低了能耗,并且更重要的是降低了运营复杂度,提高了制冷节能的稳定性。

相比于第一代宝安机房的末端冷量优化,第二代天津数据中心Data Center优化冷源产冷,第三代数据中心Data Center制冷节能更多的是体现在制冷精细化方面:

第三代制冷节能原因分析

精细化制冷节能,包括四个方面:1、由于列间空调就近送风,送风距离短,可以适当的提高送风温度和冷冻水温度,从而利于提高了制冷蒸发温度,提高冷机制冷效率;2、通过大量运用CFD有限元仿真,确定了模块内最优的颗粒度和布局,使得温度场更加合理;3、微模块分批启用,减少冷量的无效循环,让冷风送到需要的IT设备位置,从而减小风阻,降低风机功耗;4、标准化的设置、产品化的交付,在线监控预警,避免由于节能目的而造成了稳定性降低。

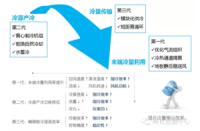

小结:前面回顾了腾讯目前数据中心Data Center制冷节能的发展历程,看似在时间和地域都存在较大跨度的三代制冷节能解决方案,实则却存在一定规律和联系。如下图:

腾讯历代数据中心Data Center制冷节能小结

数据中心Data Center制冷,其实就是一个冷量搬运的过程,分为冷源产冷、冷量传输和末端冷量利用三个环节。腾讯的三代数据中心Data Center制冷节能则是分别在三个环节上做文章,从而合力达到制冷节能的目的。也许,这就是数学和逻辑的道理。(未完待遇,敬请期待)