中国存储网消息,软件定义内存 Kove:SDM 的创建者 Kove 公布了基准测试结果,证明 Redis 和 Valkey(人工智能推理中使用最广泛的 2 个引擎)在大多数情况下,当通过 Kove:SDM 由远程内存提供支持时,运行工作负载的速度比本地 DRAM 快 5 倍,Kove:SDM 是世界上第一个也是唯一一个商用软件定义内存解决方案。

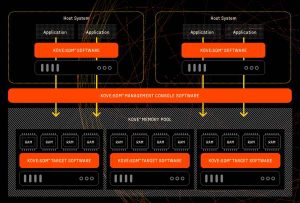

Kove:SDM 使用池内存,在 Linux 支持的任何硬件上运行,允许技术人员根据需要动态调整内存大小。这可以实现更好的推理时间处理、更快的解决方案时间、更高的内存弹性并大幅减少能源。该公告是在首席执行官约翰·奥弗顿 (John Overton) 在 2025 年 AI 基础设施峰会的主题演讲中宣布的,将内存(而不是计算)确定为扩展 AI 推理的下一个瓶颈。

虽然 GPU 和 CPU 继续扩展,但传统的 DRAM 仍然是固定的、碎片化的和未充分利用的——停滞推理工作负载,产生不必要和重复的 GPU 处理,并由于 GPU 利用率低下而推高成本。分层到 NVMe 存储有助于减少 GPU 重新计算,但与系统内存相比,性能也会大大降低。相反,Kove:SDM 跨服务器虚拟化内存,创建更大的弹性内存池,其行为和性能与本地 DRAM 类似,以突破继续限制横向扩展 AI 推理的“内存墙”。借助 Kove:SDM,KV 缓存可以保留在内存中,而不会因跨 HBM、内存和存储分层而导致性能下降。内存中发生的事情会留在内存中。

Redis 和 Valkey 基准测试:AI 推理

证明 与本地服务器内存相比,Kove:SDM 提高了容量和延迟。独立基准测试在同一台服务器上运行,首先没有 Kove:SDM,然后使用 Kove:SDM,跨 Oracle Cloud Infrastructure。与本地内存相比,Kove:SDM 的内存增加了 5 倍,服务器性能为:

Redis 基准测试 (v7.2.4)

- 第 50个百分位数:SET 快 11%,GET 快 42%

- 第 100个百分位数:SET 慢 16%,GET 快 14%

Valkey 基准测试 (v8.0.4)

- 第 50个百分位数:SET 快 10%,GET 快 1%

- 第 100个百分位数:SET 快 6%,GET 快 25%

“这些结果表明,软件定义内存可以通过消除 KV 缓存驱逐和冗余 GPU 计算来直接加速 AI 推理,”Kove 首席执行官 John Overton 说。“每个不触发重新计算的 GET 都会节省 GPU 周期。对于大规模推理环境,这意味着每年节省数百万美元。

Redis 长期以来一直为跨行业的缓存工作负载提供支持。Valkey 是 Redis 的新分支,现已广泛集成到 vLLM 中,使其成为现代推理管道的核心。通过扩展 KV 缓存容量和提高性能,Kove:SDM 直接解决了 AI 最紧迫的挑战之一。

结构性业务影响

大规模部署人工智能的企业将受益于显着的财务节省:

- 大规模部署通常每年节省 30–40M+ 美元。

- 通过推迟昂贵的高内存服务器更新,硬件支出降低 20-30%。

- 通过提高内存效率,功耗和冷却成本降低 25–54%。

- 通过消除导致故障的内存瓶颈,避免了数百万人的停机时间。

“Kove 创造了一个新类别——软件定义内存——使 AI 基础设施既具有性能又具有经济可持续性,”Kove GTM 战略总监 Beth Rothwell 说。“这是人工智能堆栈中缺失的一层。没有它,人工智能就会碰壁。有了它,AI 推理可以扩展,GPU 可以忙于做正确的工作,企业可以节省数千万美元。

为什么存储性能很重要

人工智能需求每 6-12 个月翻一番,而 DRAM 预算却跟不上步伐。分层 KV 缓存或存储卸载等现有解决方案会降低效率或增加延迟。相比之下,Kove:SDM 跨服务器池化 DRAM,同时提供本地内存性能。KV 缓存分层到存储的性能可能比 Kove:SDM 低 100-1000 倍。

Kove:SDM 可用,无需更改应用程序或代码即可部署,并在 Linux 支持的任何 x86 硬件上运行。