以 GPU 为例。SIMD的伟大之岛,使矩阵数学的轻松工作变得轻松。 它最初设计用于在计算机显示器上快速绘制点,后来 被 HPC 从业者发现非常有用。进入 GenAI,现在这些小矩阵专家的需求量很大,以至于我们称之为 GPU Squeeze。

知名且占主导地位的市场领导者 Nvidia 已经为 GPU 技术绘制了大部分道路。对于 HPC、GenAI 和大量其他应用程序,连接 GPU 提供了一种解决更大问题和提高应用程序性能的方法。

有三种基本方法可以“连接”GPU。

1. PCI总线:一个标准服务器通常可以在PCI总线上支持4-8个GPU。通过使用GigaIO FabreX内存结构等技术,这个数字可以增加到32个。CXL 也显示出希望,但是,Nvidia 的支持很薄弱。对于许多应用程序,这些可组合的 GPU 域代表了下面提到的 GPU 到 GPU 纵向扩展方法的替代方案。

2. 服务器到服务器互连:以太网或 InfiniBand 可以连接包含 GPU 的服务器。此连接级别通常称为横向扩展,其中速度较快的多 GPU 域由速度较慢的网络连接,形成大型计算网络。自从比特开始在机器之间移动以来,以太网一直是计算机网络的主力军。最近,该规范通过引入超级以太网联盟来提供高性能。事实上,英特尔已经在以太网山上插上了互连旗帜,因为英特尔 Gaudi -2 AI 处理器在芯片上具有 24 个 100 Gb 以太网连接。

英伟达没有加入超级以太网联盟,因为他们在 2019 年 3 月收购 Mellanox 后基本上拥有高性能 InfiniBand 互连市场的唯一所有权。Ultra Ethernet Consortium 旨在成为其他人的“InfiniBand”。需要明确的是,英特尔曾经打着InfiniBand的旗号。

3. GPU 到 GPU 互连:认识到需要快速且可扩展的 GPU 连接,Nvidia 创建了 NVLink,这是一种 GPU 到 GPU 连接,目前可以在 GPU 之间以每秒 1.8 TB 的速度传输数据。还有一个 NVLink 机架级交换机,能够在非阻塞计算结构中支持多达 576 个全连接的 GPU。通过 NVLink 连接的 GPU 称为“pod”,以表示它们有自己的数据和计算域。

就其他人而言,除了用于连接 MI300A APU 的 AMD Infinity Fabric 之外,没有其他选择。与InfiniBand/以太网的情况类似,需要某种“Ultra”竞争对手联盟来填补非Nvidia的“pod空白”。事实也正是如此。

AMD、博通、思科、谷歌、惠普企业 (HPE)、英特尔、Meta 和 Microsoft 宣布,他们已联合开发一项新的行业标准,致力于推进纵向扩展 AI 加速器的高速和低延迟通信。

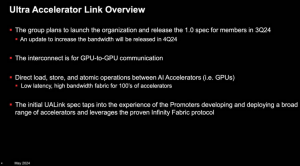

这个被称为 Ultra Accelerator Link (UALink) 的初始小组将定义并建立一个开放的行业标准,使 AI 加速器能够更有效地进行通信。通过创建基于开放标准(阅读为“非 Nvidia”)的互连,UALink 将使系统 OEM、IT 专业人员和系统集成商能够为其 AI 连接数据中心的集成、更大的灵活性和可扩展性创建一条途径。

推动 AI 工作负载的纵向扩展

与 NVLink 类似,拥有一个强大、低延迟和高效的纵向扩展网络至关重要,该网络可以轻松地将计算资源添加到单个实例(即将 GPU 和加速器视为一个大系统或“pod”)。

这就是 UALink 和开放的行业规范对于标准化下一代硬件的 AI 和机器学习、HPC 和云应用程序接口至关重要的地方。该小组将开发一种高速、低延迟的互连规范,用于人工智能计算舱中加速器和交换机之间的纵向扩展通信。

1.0 规范将支持在 AI 计算 Pod 中连接多达 1,024 个加速器,并允许在 Pod 中连接到加速器(如 GPU)的内存之间直接加载和存储。UALink 发起人集团已成立 UALink 联盟,预计将于 2024 年第三季度注册成立。1.0 规范预计将于 2024 年第三季度推出,并提供给加入 Ultra Accelerator Link (UALink) 联盟的公司。

UALink Scale-up Pod 将来自多个服务器的 GPU 合并到一个计算域中(来源:UALink Consortium) 竞争造就了奇怪的同床异梦

英伟达的主导地位通过推动竞争对手 AMD、英特尔和博通组建财团清楚地证明了这一点。特别是过去,英特尔在新技术方面经常采取“单打独斗”的策略。在这种情况下,英伟达的压倒性优势一直是所有财团成员的主要动机。

正如所宣布的那样,Ultra Accelerator Link将是一个开放标准。这一决定应该有助于更快地将其推向市场,因为需要讨价还价的 IP 会更少,但考虑到昨天对大规模 AI GPU 矩阵引擎的需求,乐观的 2026 年发布似乎还很遥远。

为了支持UALink的努力,超级以太网联盟(UEC)主席J Metz博士分享了他的热情,“在很短的时间内,技术行业已经接受了AI和HPC所发现的挑战。在寻求提高效率和性能时,像 GPU 这样的互连加速器需要从整体角度考虑。在UEC,我们相信UALink解决pod集群问题的扩展方法补充了我们自己的横向扩展协议,我们期待共同合作创建一个开放的、生态系统友好的、全行业的解决方案,以满足未来的这两种需求。

UALink 概述(来源:UALink Consortium)