在一年一度的GPU Technologies大会上,Nvidia发布了据它称是目前最大的16纳米FinFET芯片,以及封装了8个这种芯片的一款高端系统。Tesla P100芯片以及DGX-1服务器是最新的图形处理引擎,瞄准深度学习算法。

在关于计算机游戏的主题演讲中,Nvidia首席执行官黄仁勋展示了未来一切都将采用新兴的人工智能技术,从下一代云服务到汽车。

“深度学习不再只是研究,而是发生在各行各业,”黄仁勋表示。他将新兴的神经网络算法称为“一种新的计算模式”,“计算领域将要发生的最重要的事情之一”,“未来10年将会在每个行业和应用领域创造5000亿美元的机会”。

例如,P100(也就是此前的Pascal)将用于一款汽车主板上,将有助于开发自动驾驶使用。在对该技术的一项测试中,Nvidia将把这种芯片接入20台处于自动驾驶竞赛模式的无人驾驶电动赛车中。

首席执行官黄仁勋正在将Nvidia打造成为深度学习领域的一个新的“杀手级应用”。

“这场竞赛从耗费大量预算的机制测试转向对神经网络的软件竞争,”Nvidia汽车部门高级总监Danny Shapiro表示。

Nvidia正在提供自动驾驶系统的原型,80家汽车制造商和学者正在使用PDX2板卡,该板卡连接多达12个高清摄像头和其他传感器,Shapiro表示。

在云计算方面,百度高级研究员Bryan Catanzaro表示,他的实验室希望神经运行的速度提高30倍,将数据分散到8个P100芯片组成的集群上,该集群则是借助P100新的互连技术实现的。

黄仁勋表示,Google正在开源自己的TensorFlow人工智能框架。“我们确实认为深度学习将成为一切的组成部分,不仅是是针对数据中心,还有嵌入式系统和手机等各种各样的事物,”Google TensorFlow技术主管Rajat Monga这样表示。

另外,黄仁勋表示,虚拟现实正在作为一种新的计算平台崛起,Nvidia承诺将会给给领域的初创公司提供15亿美元资金。他邀请苹果联合创始人Steve Wozniak体验Mars 2030——一个将在今年秋季发布的虚拟现实环境。

此外,Nvidia还公布了两个VR版本的渲染系统,针对光线追踪。黄仁勋展示了其中专业VR系统,显示Nvidia正在建设中的新总部,另外一个是针对消费者的,采用安卓查看器。

Nvidia的Pascal将成为机器人竞赛中无人驾驶电动汽车的司机。

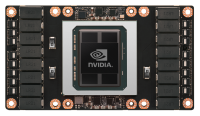

Pascal围绕着一个16纳米的FinFET GPU,带有HBM2内存,采用TSMC的CoWoS制程。

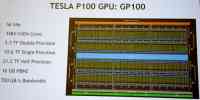

Tesla P100(也就是Pascal)将16GBytes HBM2 DRAM置于一个720GByte/s CoWoS (Chip-On-Wafer-On-Substrate)上。该GPU封装了3584个Nvidia Cuda核心,600mm2模片上有150亿个晶体管。

“这是目前最大的16纳米FinFET芯片,”Nvidia GPU工程高级副总裁Jonah Alben这样表示。

Alben指出,该中介层要求光罩缝合,因为它要比光罩大。该芯片的未来版本可能会在TByte/s总线上支持32GByte,他暗示说。

Pascal瞄准像深度学习系统这样的高性能计算任务。它会赶超来竞争对手AMD去年发布的Fiji芯片,更多地瞄准高端游戏领域。

每个芯片上的60个GPU块,旨在最大利用每个块中的56个核心。因此,核心周围配置了更多资源,包括寄存器数量翻番,共享内存比上一代多出了1/3。

这款芯片是Nvidia首次支持半精度,据称这对于深度学习、传感器数据和图像处理等应用是很有用处的。

该处理器正在进行量产,但是还没有出货,Nvidia表示它将出现在从今年6月开始出货的DGX-1服务器中。

Nvidia Pascal显微照片和关键指标

上面的Pascal横断面显示了四高HBM堆栈,以及硅光罩,采用4000条线连接内存和GPU。HBM2芯片支持ECC,这是设计者在早期GDDR内存中必须采用的。

对于开发者来说,这就像是全局内存一个更大、更快的块。49字位的虚拟内存空间可以支持数千个默认页和2 Mbyte页面大小。得到的统一内存系统可以将整个物理内存空间分配在一个系统中,可以跨CPU和GPU访问块,并且支持原子操作。

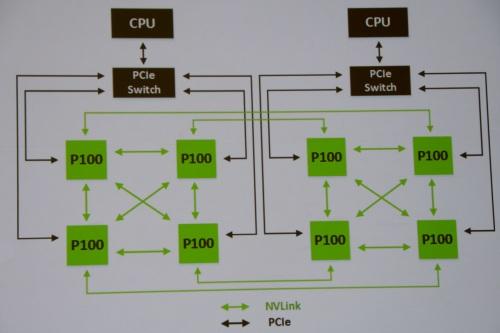

覆盖一系列深度学习任务(如下)的结果显示,两个Pascal芯片的性能要超过4个上一代Kepler处理器。蓝线的意思是结果低于英特尔Hashwell CPU。当4个和8个Pascal芯片做成集群的时候,系统很好地进行伸缩,很大程度上是因为采用了Pascal新的NVLink技术。

Nvidia混合采用NVLink(绿色)和PCIe(黑色)连接GPU和CPU

Pascal是首款采用Nvidia NVLink的芯片,这是一种芯片到芯片的互连技术,最多可包括4个40 Gbit/s的连接。它旨在将8个Nvidia GPU做成集群,或者GPU和CPU的混合,例如将支持NVLink的IBM Power8处理器。

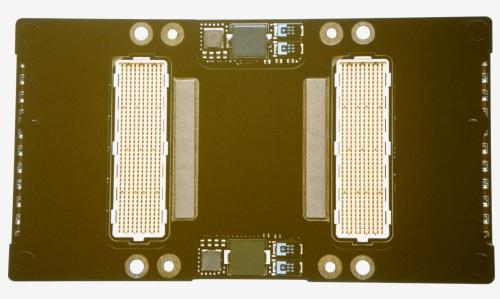

NVLink是一种连贯的互连,所以程序员看到的有点类似于跨芯片的本地内存。在物理层上,板卡设计者会看到承载NVLink、PCIe和电源信号的Pascal模块连接(如下)。

Pascal芯片堆栈下的模块连接器。

DGX-1是一款封装了最多8个GPU的3U服务器。

借助DGX-1,Nvidia将自己的足迹扩大到GPU计算系统领域。它在一台3U服务器内封装了8个Pascal芯片,交付170 TFlops性能,功耗是令人惊讶的3200瓦。该系统还包括一个7TB的固态盘,以及一个支持10Gb和100Gb Infiniband的网络控制器。

Nvidia宣称DGX-1可以将培训Alexnet的时间缩短到2个小时,而以前这在一台双路英特尔至强服务器上需要花费150小时。

Nvidia将在6月开始出货这款芯片和系统。OEM厂商包括Crap、戴尔、HPE和IBM,这些厂商将从明年年初开始出货各自的系统。