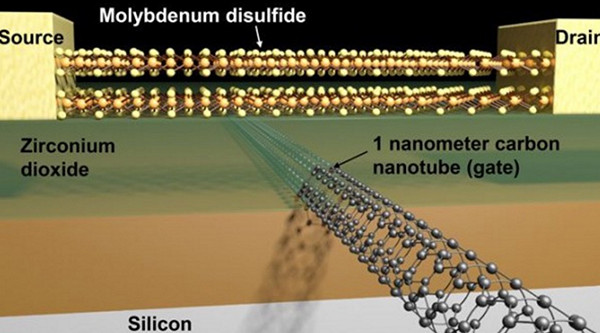

近日据国外媒体报道,已经沉寂多年的计算技术界在劳伦斯伯克利国家实验室的努力下诞生出了一个新的重大突破,那就是将现有最精尖的晶体管制程从14nm缩减到了1nm。

我们都知道,晶体管的制程大小一直是计算技术界进步的重要标杆,晶体管越小,同样体积的芯片上就能集成更多,这样一来处理器的性能和功耗都能会获得巨大进步。

这么多年以来,此项技术的发展一直都在遵循着摩尔定律,也就是说,当价格不变的情况下,集成电路上可容纳的元器件的数目,约每隔18-24个月便会增加一倍,性能也将提升一倍。换言之,每一美元所能买到的电脑性能,将每隔18-24个月翻一倍以上。

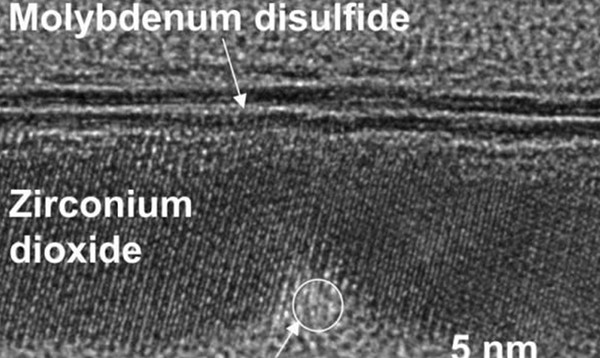

不过有研究科学家们指出,在未来很有可能摩尔定律会失灵,因为从芯片的制造来看,7nm就是物理极限。一旦晶体管大小低于这一数字,它们在物理形态上就会非常集中,以至于产生量子隧穿效应,为芯片制造带来巨大挑战。因此,业界普遍认为,想解决这一问题就必须突破现有的逻辑门电路设计,让电子能持续在各个逻辑门之间穿梭。