重复数据删除技术能够识别重复的数据,消除冗余,减少需转移或存储的数据的总 体容量。重复数据删除技术检测重复的数据元素,判断一个文件、块或比特是否和另 一个文件、块或比特相同。重复数据删除技术将每个数据元素用数学的"哈希"算法来进 行处理,并得到一个名叫哈希码的唯一的认证数。每个数字都被编译到一个清单,这个 清单经常被称为哈希索引。 目前主要有文件级、块级和字节级删除策略,它们都能优化存储容量。

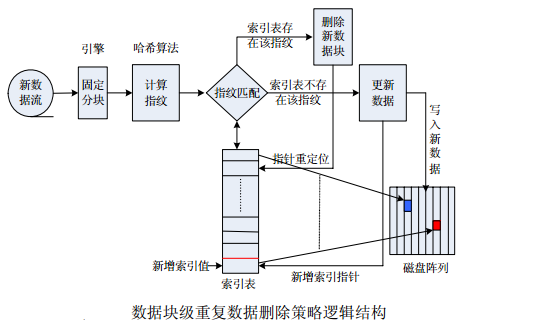

数据块级重复数据删除策略也是基于散列的方法,通常采用 SHA-1、MD-5 算法, 把来自备份软件的数据流分成固定的数据块,然后为每个数据块生成一个独特的指纹。 如果新数据块的指纹与设备散列索引中的某个散列匹配,仅存入指针,并指向存储相同 数据块的原始位置。否则,如果数据块是唯一的,就被写入磁盘,其指纹也存入索引中; 这种方法用小容量的指针替代重复的数据块,而不是将重复数据块再次存储,这样就节 省了磁盘存储空间,其逻辑结构图如下: