人工智能将继续存在,并正在成为服务器和 PC 上处理的工作负载的重要组成部分。

这就是为什么英伟达作为芯片制造商取得了成功,并且人们对 Meta 的开源 Llama 等大型语言模型感到兴奋。热切的观众希望掌握这些模型以获得答案并自动化平凡的流程。

通常不包括 PC,但这些设备可以派上用场,以减轻服务器芯片上的 AI 负载。远程 HPC 工作(本地或云)通常从笔记本电脑或台式机开始。PC 在推理方面非常高效,而目前这主要在服务器上完成。PC 在从 Llama 等可访问的开源模型生成输出时可能比服务器更节能。

目前在 PC 上处理 AI 的方法很复杂。它需要跳过重重障碍才能在 PC 上加载变压器模型。在大多数情况下,人们需要 Nvidia 的 GPU 等硬件。然后,用户必须创建一个本地神经网络,下载 PyTorch 环境,并让 Python 从 GitHub 和 Hugging Face 中提取相关的 transformer 模型。

许多版本的 GenAI 模型不是为 Nvidia 的 GPU 设计的,而是默认为 CPU。PC 还需要巨大的内存容量。此技术不能保证在浏览器界面中运行的稳定 AI 环境。用户需要在每次重启时重启 AI 环境。

最近在CES贸易展上展示的Meteor Lake PC已经实现了整个过程的自动化。例如,PC 可以在 PC 环境中本地运行 Llama 2 聊天机器人,并减轻服务器负载。几个月来,Hugging Face 在其 HuggingChat 网站上安装了 Llama 2 聊天机器人,并在服务器 GPU 上进行处理。聊天机器人现在运行具有 80 亿个参数的 Mixtral 模型。

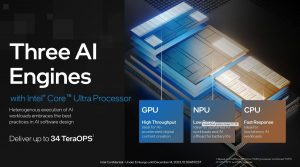

英特尔 Meteor Lake 包括异构 AI 功能,包括 NPU(低功耗)、GPU(高吞吐量)和 CPU(快速响应) 来源:英特尔

英特尔的 Meteor Lake 有一个神经处理单元,可以处理 Llama 2 的推理。配备芯片的惠普 PC 和 Microsoft 的 Windows 11 具有与 Llama 2 的聊天机器人界面,可通过单击图标立即加载。这消除了使用命令行加载神经网络环境、Python 和其他环境的复杂性。

Microsoft 的 DirectML 驱动程序集 - 与图形的 DirectX 驱动程序非常相似 - 提供了在具有 Intel NPU 的 PC 上进行推理处理所需的中间件。英特尔已经为其 Meteor Lake 芯片中的神经处理单元预训练了 Llama 2。驱动程序基于 ONNX 运行时,该连接器可与 Nvidia、Intel 和 AMD 的软件堆栈配合使用。

英特尔无法为其 NPU(神经处理单元)预训练封闭模型,例如 OpenAI 的 GPT 模型和 Google 的 Gemini。但是客户可以从 PC 连接到 GPT-4,客户可以在 AI 软件中选择首选模型,该模型将用户查询发送到服务器。

英特尔高管表示,它正在为其NPU预训练更多模型,这些模型最终将在Meteor Lake PC上提供。支持模型可能是开源的。

英特尔高管表示,开发人员还可以下载可以为英特尔NPU加载的模型。这些模型将从 ModelZoo 获得,ModelZoo 是英特尔的 GitHub 站点,用于下载模型。

这会产生涓滴效应——GPU 和服务器将可以自由地处理更相关的任务,例如训练。将推理从服务器卸载到 PC 是合乎逻辑的下一步,因为生成式 AI 使服务器基础设施不堪重负。谷歌、Microsoft 和 Meta 正在建立服务器容量以应对 AI 的冲击。

英特尔公司副总裁兼至强公司总经理Lisa Spelman在接受HPCwire采访时表示,英特尔正试图建立一个连续体,其中某些处理在其Xeon芯片上完成,然后启动到数据路径中的其他芯片。

“我们实际上在追求什么......是无缝流程的客户价值,不需要用户干预,“Spelman说。

由于构建数据中心基础设施的成本和复杂性,AI 的运行成本很高。Microsoft 正在围绕 Nvidia GPU 构建其服务器 AI 能力,但也在销售在 Azure 服务器上运行的 GPT-4 服务。该公司正在花费大量资金运行 AI 交易,并试图平衡其 Nvidia GPU 使用能力,同时从每次查询中产生更多收入。

可以肯定的是,将 AI 卸载到客户端设备并不是什么新鲜事——它已经在集成了 Bing 的 Windows 11 PC 中发生。谷歌正在其 Pixel 手机中集成其 Gemini 功能。AMD还在其PC芯片中集成了神经处理器,并与PyTorch和Hugging Face合作,为其GPU和AI芯片调整生成式AI技术。

人工智能正在接管更多的PC功能,芯片制造商正在意识到这一趋势。障碍是在 PC 上运行 AI,超出了 Nvidia 的主导地位。

英特尔还在花时间构建软件生态系统,将其芯片用于人工智能。双重策略涉及将开发人员迁移到OneAPI和开源OpenVINO堆栈,使开发人员更容易为AI芯片编写应用程序。

另一个组件是对 SYCL 的支持,它将 Nvidia 的软件堆栈用户(CUDA 开发人员)从该专有环境移植到开源代码上。无论是英特尔芯片还是 AMD GPU,都没关系。SYCL 的目标是打破 Nvidia 在 AI 市场上无情的硬件和软件主导地位。

英特尔还远未推出连贯的硬件和软件堆栈。该公司提供一系列硬件选项,包括 Habana 2 AI 芯片,这是该公司对 Nvidia H100 和 H200 GPU 的回应。该公司已将 AMX 加速器内置到服务器 CPU 中,并提供用于计算机视觉的 Movidius AI 芯片。英特尔的高性能 GPU 战略正在中断,下一个主要的 Falcon Shores GPU(将与 Habana AI 电路集成)计划于明年发布。

英特尔提供开发人员云,它为开发人员提供了大量基于云的芯片,以测试其人工智能应用程序的性能和功能。但是,该实现存在问题,没有明确的定价或面向开发人员的 Jupyter Notebook 实现。该界面不像 Google Cloud 的 Vertex 或 Google Colab 等服务那样精致,后者提供了许多 AI 芯片选项并使用 Google Drive 进行存储。

英特尔也没有传达开发者云的定价。英特尔高管们已经接受了我对这项服务的抱怨,并理解Developer Cloud对吸引更多开发者的重要性。

英特尔还表示,它将为开发人员提供 Cnvrg.io 服务,以比较不同云服务之间的AI性能。英特尔于 2020 年收购了 Cnvrg.io,并在 2022 年底暗示将在 2023 年推出 Cnvrg.io 的更新版本,但尚未发布此类公告。