DeepSeek R-1 的迅速崛起使一种称为推理模型的新兴 AI 模型成为人们关注的焦点。随着生成式 AI 应用程序超越对话界面,推理模型的功能和使用可能会增加,这就是为什么它们应该出现在您的 AI 雷达上。

推理模型是一种大型语言模型 (LLM),可以执行复杂的推理任务。推理模型不是像 LLM 通常那样仅根据对答案中下一个单词的统计猜测来快速生成输出,而是需要时间将问题分解为单独的步骤,并通过“思维链”过程得出更准确的答案。以这种方式,推理模型的方法更像人类。

OpenAI 于 2024 年 9 月推出了其第一个推理模型,称为 o1。在一篇博文中,该公司解释说,它使用强化学习 (RL) 技术来训练推理模型来处理数学、科学和编码中的复杂任务。该模型在物理、化学和生物学方面的表现达到了博士生的水平,同时超过了博士生的数学和编码能力。

根据 OpenAI 的说法,与早期的语言模型相比,推理模型更像人类一样解决问题。

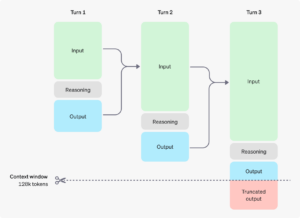

推理模型涉及一个涉及额外代币的思维链过程(图片来源:OpenAI)

“类似于人类在回答困难问题之前可能会思考很长时间,o1 在尝试解决问题时使用思维链,”OpenAI 在一篇技术博客文章中说。“通过强化学习,o1 学会了磨练其思维链并改进它使用的策略。它学会识别和纠正错误。它学会了将棘手的步骤分解为更简单的步骤。它学会了在当前方法不起作用时尝试不同的方法。这个过程极大地提高了模型的推理能力。

IBM 研究员 Kush Varshney 表示,推理模型可以检查自身的正确性,他说这代表了一种以前在 AI 中不存在的“元认知”。“我们现在开始将智慧融入这些模型,这是一大步,”Varshney 在 1 月 27 日的一篇博客文章中告诉 IBM 技术记者。

这种级别的认知能力是有代价的,尤其是在运行时。例如,OpenAI 对 o1-mini 的收费是 GPT-4o mini 的 20 倍。虽然它的 o3-mini 每个代币比 o1-mini 便宜 63%,但它仍然比 GPT-4o-mini 贵得多,这反映了在“思维链”推理过程中使用的代币数量更多,被称为推理代币。

这就是 DeekSeek R-1 的推出如此突破性的原因之一:它大大降低了计算要求。DeepSeek 背后的公司声称,它在一小群旧 GPU 上训练了其 V-3 模型,这些 GPU 的成本仅为 550 万美元,远低于据报道训练 OpenAI 最新 GPT-4 模型的成本数亿美元。而 DeepSeek R-1 的成本约为每 100 万输入代币 55 美元,大约是 OpenAI o3-mini 的一半。

DeepSeek-R1 在数学、编码和科学任务方面的得分与 OpenAI 的 o1 推理模型相当,它的惊人崛起迫使 AI 研究人员重新思考他们开发和扩展 AI 的方法。与其竞相构建具有数万亿个参数并使用从各种来源挑选的大量数据进行训练的越来越大的 LLM,不如我们见证了 DeepSeek R-1 等推理模型的成功,这表明使用专家混合 (MoE) 架构训练大量较小的模型可能是一种更好的方法。

Ali Ghodsi 是应对快速变化的 AI 领导者之一。在最近发布到 YouTube 的一次采访中,Databricks 首席执行官讨论了推理模型和 DeepSeek 崛起的重要性。

“游戏规则显然已经改变了。即使在大型实验室中,他们也将所有精力都集中在这些推理模型上,“Ghodsi 在采访中说。“所以不再 [关注] 缩放定律,不再训练巨大的模型。他们实际上把钱花在了很多推理上。

DeepSeek 和推理模型的兴起也将对处理器需求产生影响。正如 Ghodsi 所指出的,如果市场不再训练越来越大的 LLM,这些 LLM 是各种行业的通才,而是转向训练从大型 LLM 中提炼出来的更小的推理模型,并使用 RL 技术增强成为专业领域的专家,这将不可避免地影响所需的硬件类型。

“推理只需要不同种类的筹码,”Ghodsi 在 YouTube 视频中说。“它不需要这些互连这些 GPU 的网络。你可以在这里有一个数据中心,在那里有一个数据中心。你可以在那边有一些 GPU。游戏规则已经发生了变化。

Nvidia 的 RTX GPU(来源:Nvidia)

GPU 制造商 Nvidia 认识到这可能会对其业务产生影响。在一篇博文中,该公司吹捧了基于 PC 的 GPU 的 50 系列 RTX 系列(基于 Blackwell GPU)的推理性能,用于运行从 6710 亿参数的较大 DeepSeek-R1 模型中提炼出来的一些较小的学生模型。

“高性能 RTX GPU 使 AI 功能始终可用——即使没有互联网连接——并提供低延迟和更高的隐私性,因为用户不必上传敏感材料或将他们的查询暴露给在线服务,”Nvidia 的 Annamalai Chockalingam 上周在一篇博客中写道。

当然,推理模型并不是唯一的游戏。在构建检索增强 (RAG) 管道以向 LLM 提供反映正确上下文的数据方面,仍有大量投资。许多组织正在努力将图形数据库作为可以注入 LLM 的知识来源,这就是所谓的 GraphRAG 方法。许多组织也在推进使用自己的数据微调和训练开源模型的计划。

但是 AI 场景中突然出现的推理模型无疑改变了一切。随着 AI 发展步伐的不断加快,这类意外和冲击似乎可能会变得更加频繁。这可能会带来一段坎坷的旅程,但它最终会创造出更强大、更有用的 AI,这对我们所有人来说都是一件好事。